インハウスマーケティング部の井上です。

今年4月、FacebookやInstagramを運営しているMeta社から、最新のLLMモデル「Llama3」がリリースされました。性能はClaude 3 Sonnetに匹敵し、オープンソースで商用利用可能ということで、大きな注目を集めています。

Llama3はHugging FaceやAmazon Bedrockを通して利用したり、Ollamaなどのツールを使ってローカルで動かすなどさまざまな利用方法があるようですが、非エンジニアであり開発畑でもない僕にとってはちょっとハードルが高そうに見えてしまいます……!

簡単に利用できる方法がないかと探していたところ、Groqというサービスを使えばChatGPT感覚で利用できることがわかりました。

そこで今回はLlama3の特徴を解説するとともに、Groqを通して非エンジニアでも簡単に Llama3を使う方法を紹介します。

目次

Llama3とは?

Meta社が開発しているオープンソースの大規模言語モデルで、

オープンソースで商用利用可能

GPTやClaudeなど現行の主要なモデルと異なり、Llama3はオープンソースのLLMです。GPTをAPI経由で利用する場合はトークン数に応じて利用料がかかる仕組みですが、Llama3は無料で利用でき、商用利用も可能*という特徴があります。

*現時点では、月間アクティブユーザーが7億人以下の場合に限り無料

すでに社内用FAQやCS活動などでGPTを活用している企業も増えつつありますが、ランニングコストを下げたいと考えている方もきっといらっしゃるかと思います。もしGPTをLlama3に置き換えられたなら、大幅なコストダウンが見込める場合もあるでしょう。

オープンソースモデルの中ではトップクラスの性能

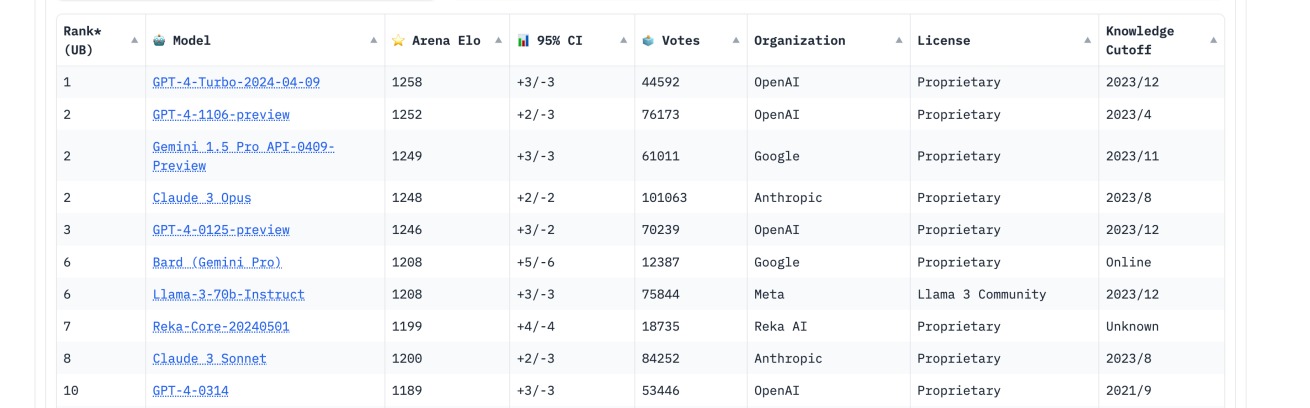

出典:LMSYS Chatbot Arena

出典:LMSYS Chatbot Arena

※2024年5月9日時点のデータです

「いくら低コストでも性能面が不安」という方もいるかもしれませんが、さまざまなLLMモデルの性能を評価しているサイト「Chatbot Arena」のリーダーボードでは、記事執筆時点でLlama3(70Bモデル)は7位にランクイン。オープンソースモデルの中ではトップクラスの性能であり、Claude 3 Sonnetよりも上位という評価を受けていました。

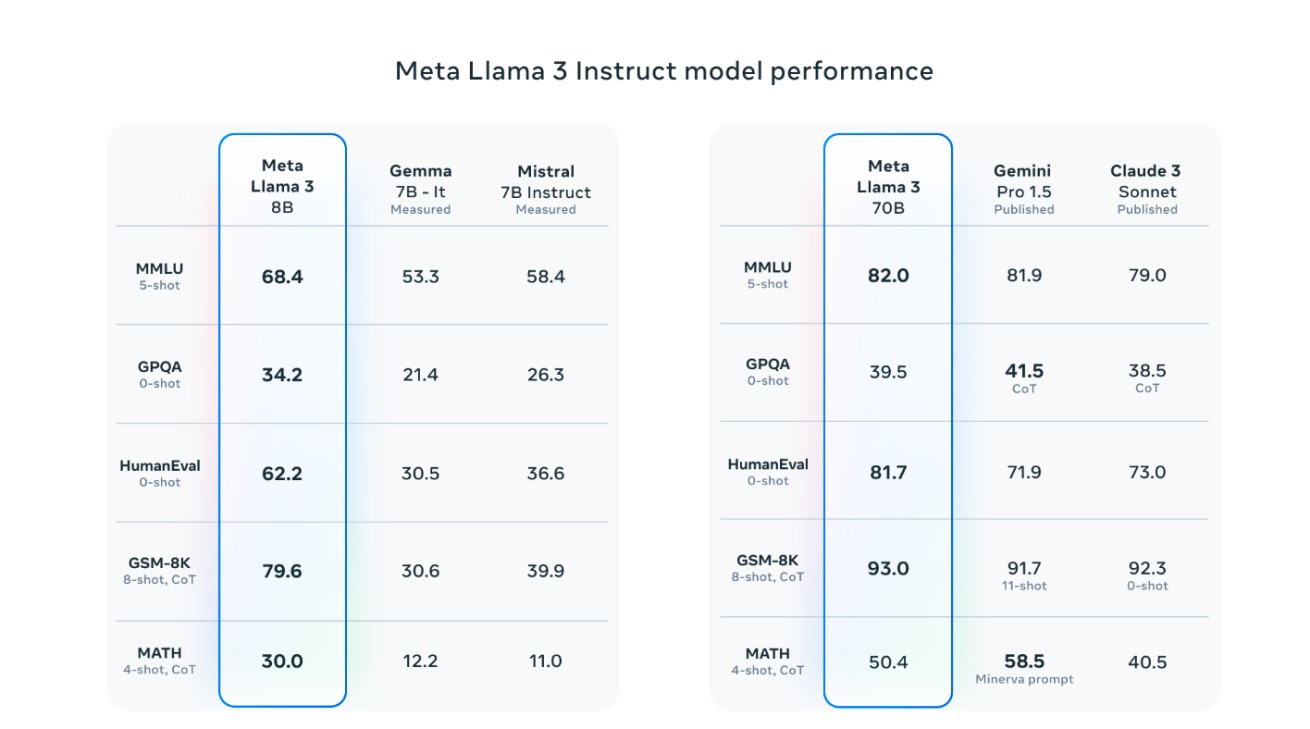

出典:Introducing Meta Llama 3: The most capable openly available LLM to date

出典:Introducing Meta Llama 3: The most capable openly available LLM to date

また、Meta社によるとLlama3は前世代のLlama2の性能を大きく上回っており、8Bおよび70Bパラメーターの他社LLMモデルと比較しても最先端のパフォーマンスを発揮しているとのことです。

Gemini Pro 1.5やClaude 3 Sonnetとのベンチマーク比較も実施されていて、いくつかの領域でLlama3の性能が上回っているという結果も出されています。オープンソースゆえにファインチューニングもおこないやすいため、活用の幅が広そうですね!

学習データの95%が英語

Llama3はリリース時点で、学習データの95%が英語データ、5%が30以上の非英語データとなっています。英語以外でも利用可能ではありますが、英語で利用したときほどのパフォーマンスは期待できないと公式で発表されています。

▼原文

To prepare for upcoming multilingual use cases, over 5% of the Llama 3 pretraining dataset consists of high-quality non-English data that covers over 30 languages. However, we do not expect the same level of performance in these languages as in English.

出典:Introducing Meta Llama 3: The most capable openly available LLM to date

今後学習データはアップデートされていく予定とのことなので乞うご期待ですね! さらに5月7日には日本のAI企業・rinna社が、日本語継続事前学習モデル「Llama 3 Youko 8B」を公開するなど、オープンソースならではの動きも活発です。

Llama3の使い方

Llama3を使うためには以下のような方法があります。

- ローカルで環境構築

- 機械学習のためのプラットフォーム「Hugging Face」を通して使用

- Meta社公式のサービス「Meta AI」から使用

ここで問題なのが、僕がエンジニアでもなく、開発畑の人でもないということです。1、2はハードルが高いためなし。3の「Meta AI」はChatGPT感覚でLlama3が使えるサービスのようですが、本記事執筆時点では日本でまだサービスを提供していませんでした。

Llama3はGroqで使える

どうしようかと思っていたところ、「Groq」というサービスを通してLlama3を使用できることが分かりました。ここからは詳しい使い方をご紹介します。

Groqとは?

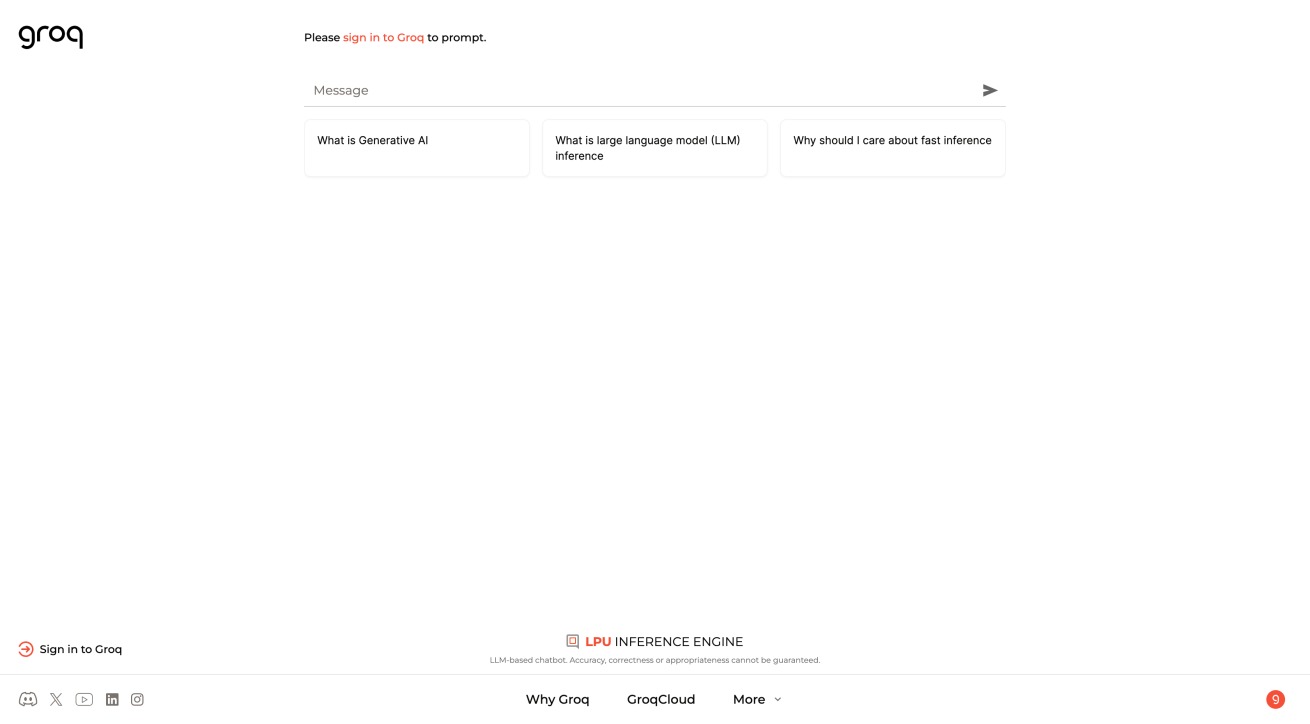

出典:Groq

出典:Groq

Groqは元Googleのエンジニア・Jonathan Rossが創業したスタートアップで、対話型生成AIサービス「Groq」を提供しています。執筆時点ではGemma、Mistral、Llama3といった、オープンソースLLMモデルが無料で利用できます。

Groq最大の特徴は、出力の速さ。LPUという独自の処理エンジンを活用しており、。

どれくらい速いのか、百聞は一見にしかずなので動画を用意してみました。

爆速すぎますね……! サンプルの質問を投げてみたところ、2秒とかからず出力してくれました。日本語訳をお願いしても同様のスピード感です。

Groqの使い方

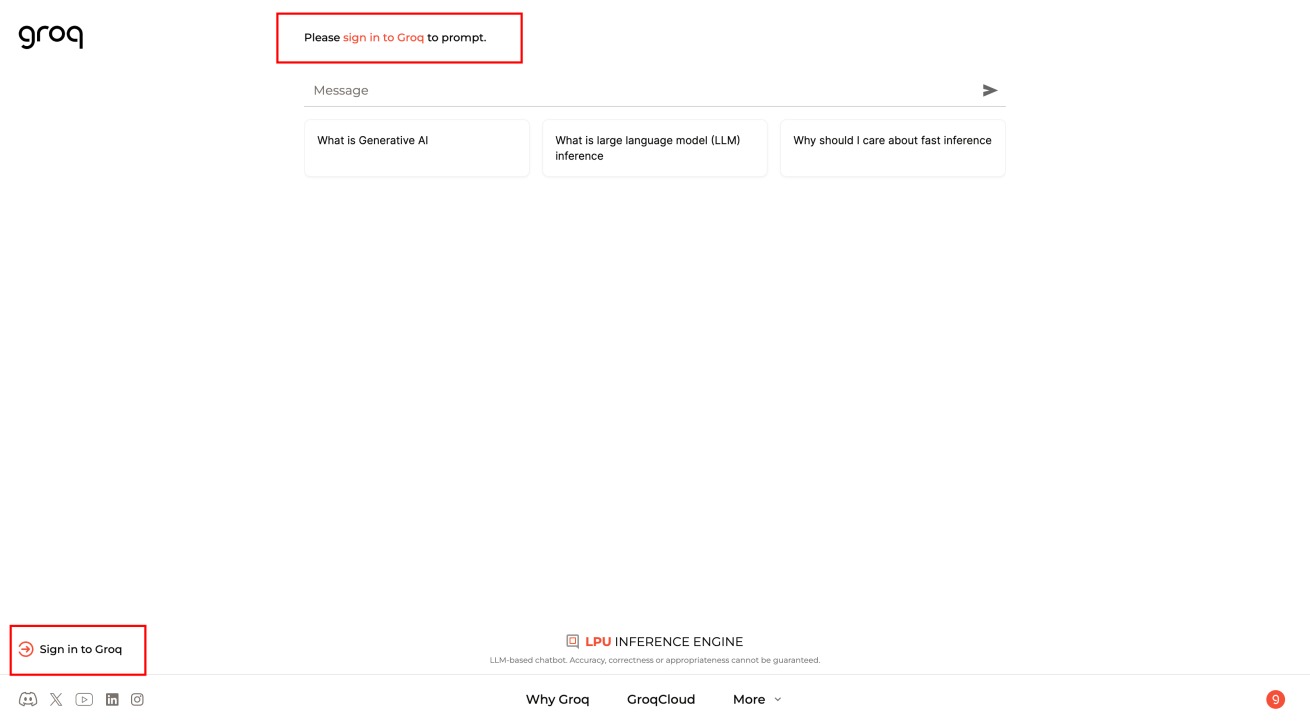

Groqは面倒な登録もなしで簡単に利用できるのもメリットです。トップページに入ったら、まずは赤枠で囲んだ部分からサインインしましょう。

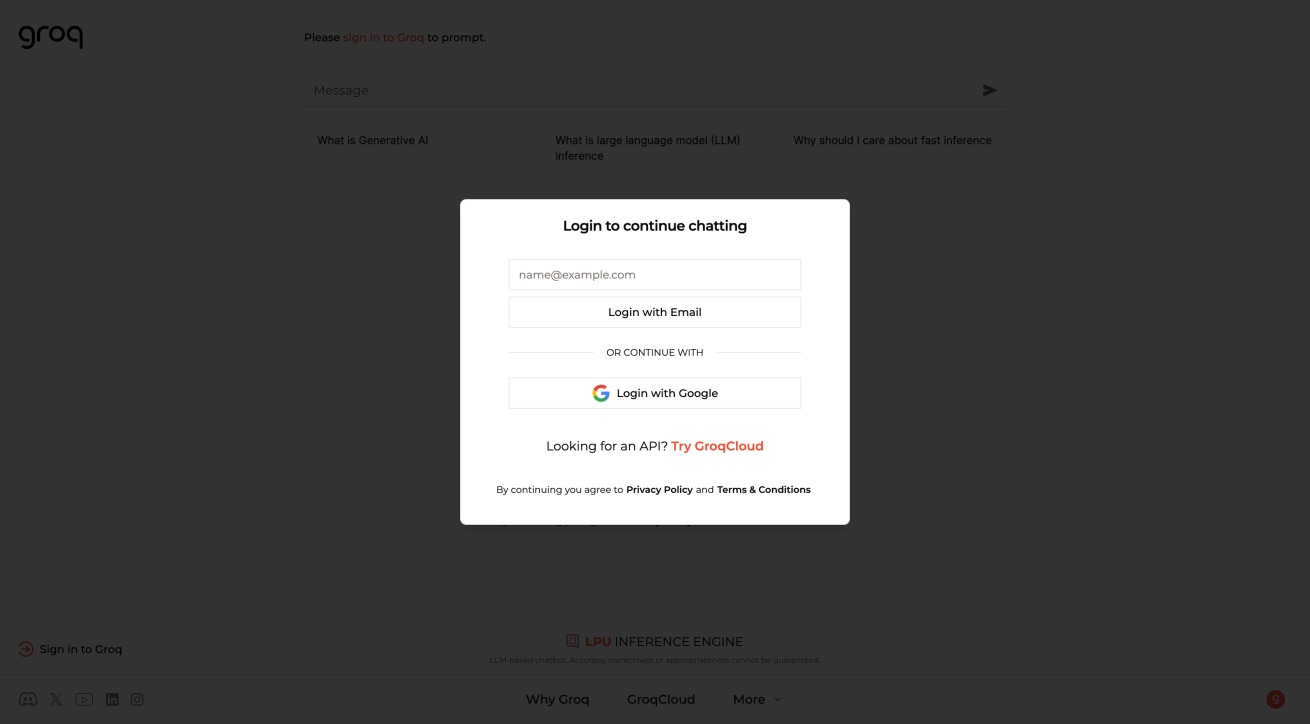

サインイン方法はメールアドレスかGoogleが選べます。

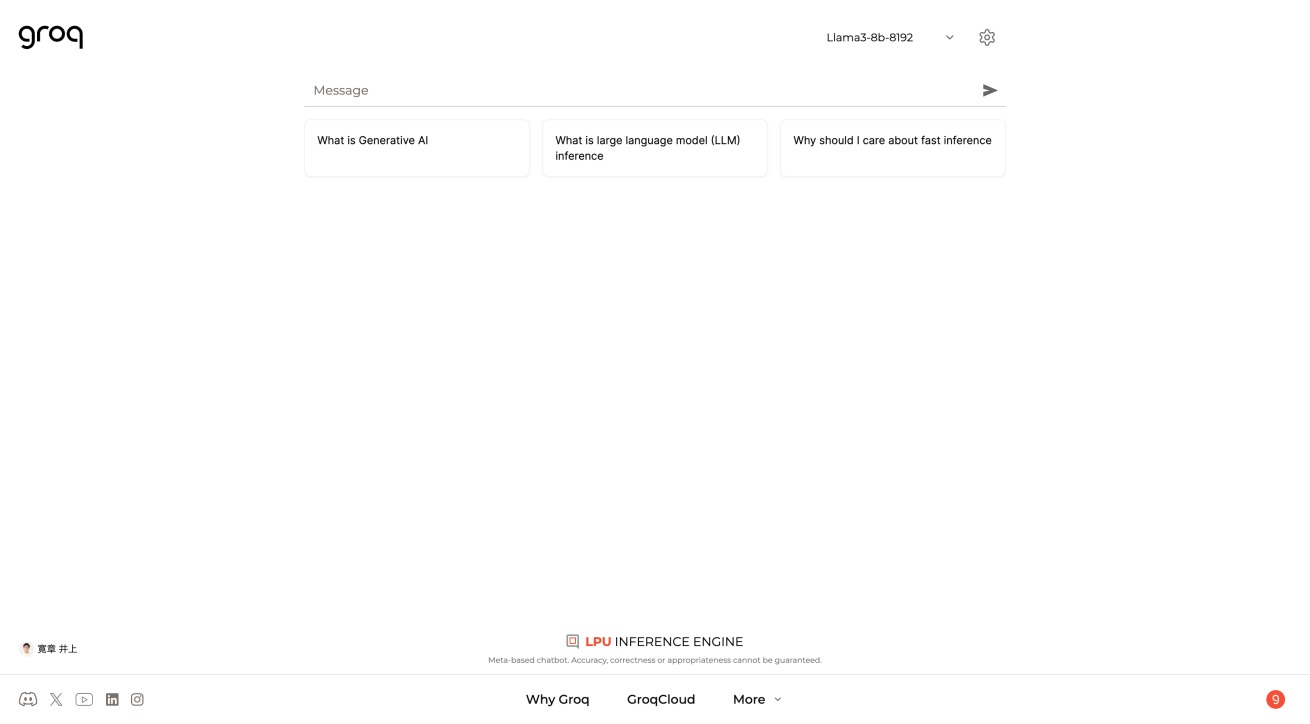

これで「Message」欄にプロンプトが入力できるようになりました。

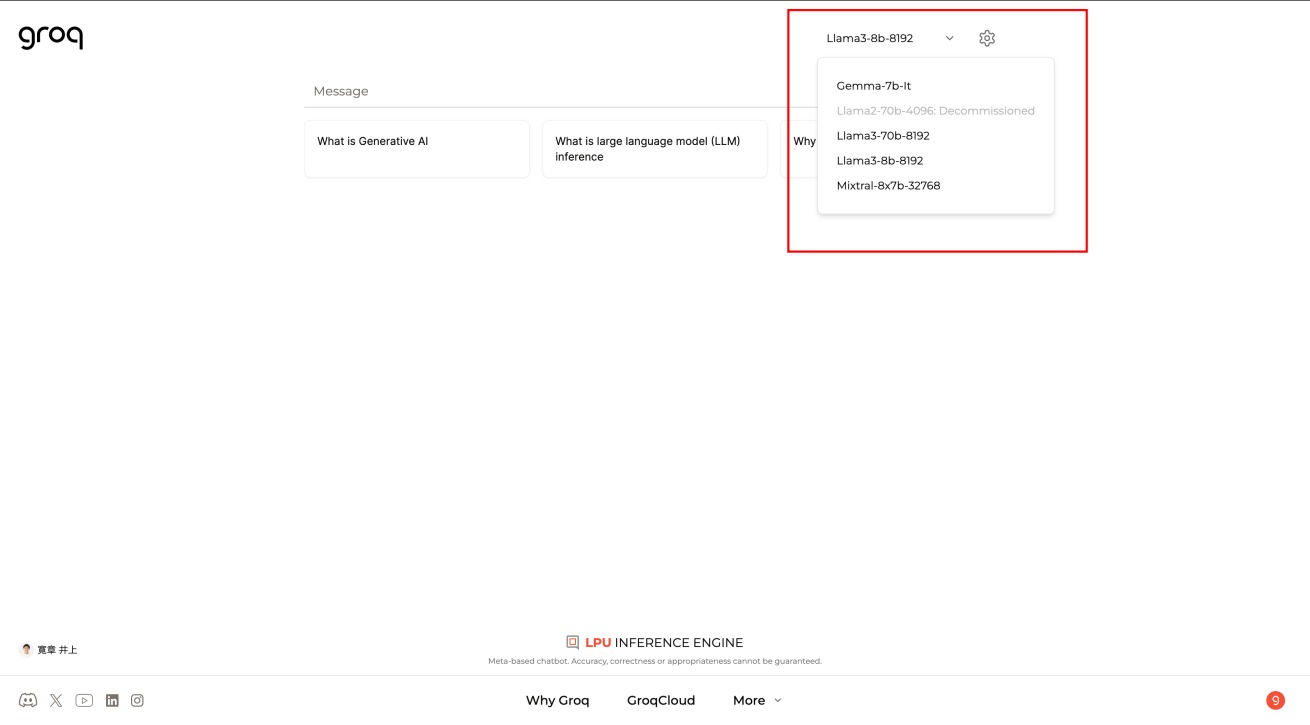

使用するモデルの変更は、ページ右上から可能です。

システムプロンプトを使いこなそう

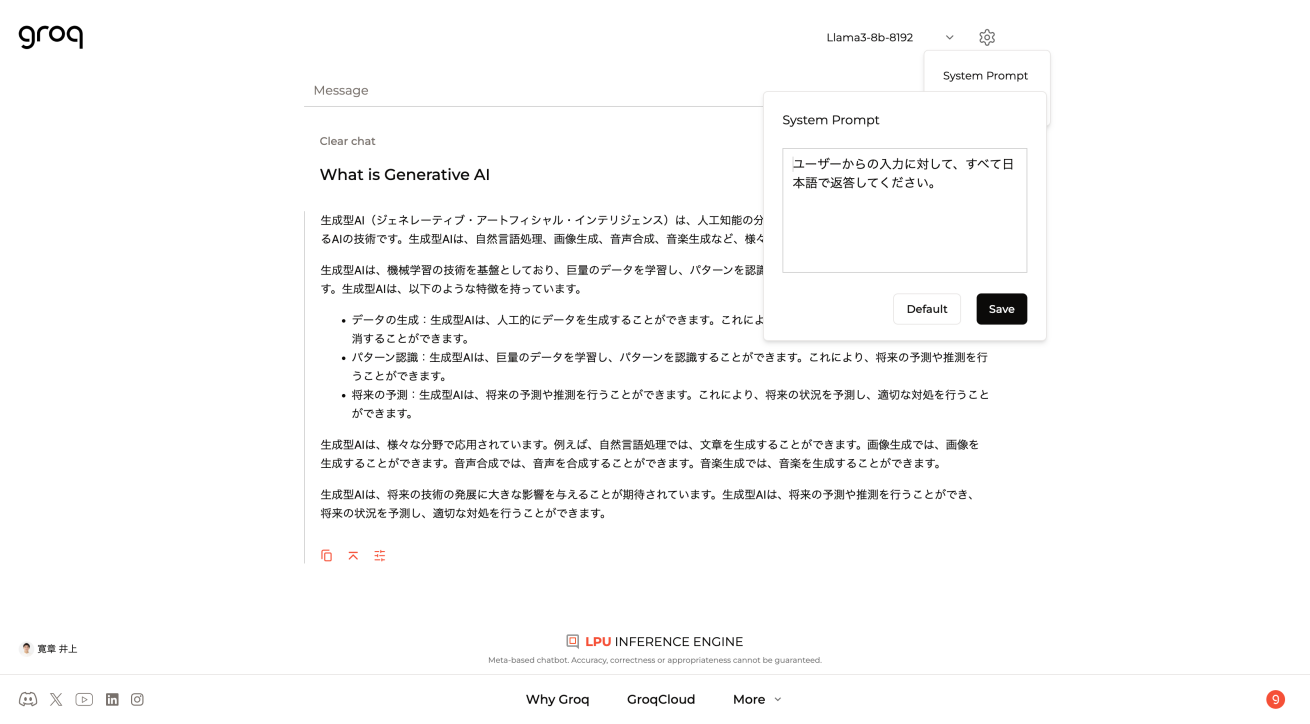

Llama3の学習データが基本的に英語を使用していることもあり、そのままの状態で使うと日本語で質問しても英語で回答を生成する場合がほとんどです。常に日本語で回答してもらいたい場合は、システムプロンプトを活用しましょう。

右上の歯車アイコンからシステムプロンプトが設定できます。システムプロンプトは、入力に対して言語モデルにどう応答してほしいのか設定するためのものです。ChatGPTのカスタム指示と似たものと考えると、イメージが湧きやすいかもしれません。

たとえば「ユーザーからの入力に対してすべて日本語で返答してください」というシンプルなプロンプトを設定するだけで、画像のように英語の質問に対しても日本語で回答を出力してくれます。用途に応じて役割を設定したり、口調(スタイル)を設定するなどさらに工夫もできそうです。

まとめ

Meta社のLLM「Llama3」の特徴と、Groqを通した使い方を紹介しました。

オープンソースで高性能なモデルが登場したことで、低コストかつ実用的なAI導入が可能になったと考えられています。オープンソースならではの拡張性やカスタマイズの自由度が強みなので、より活用するためには専門家や外部パートナーとの体制も構築しつつ、自社の課題にあわせたファインチューニングをおこなっていくことも重要です。

弊社LIGでは生成AIのコンサルティングもおこなっています。Llama3をはじめ、「生成AIを業務に活用したい」「自社課題に応じた生成AI活用方法をコンサルティングしてほしい」など、さまざまなニーズにお応えできますので、ぜひお気軽にご相談ください。